最近的ChatGPT很火, 我也来凑个热闹![]()

这个项目是逛知乎的时候看到的, 看介绍说对标ChatGPT, 就很好奇达到了怎样的效果

部署不难, 简单记录下吧, GitHub repo如下:

以下教程为NVIDIA GPU版本, 不包含CPU

第一步: 确认装好显卡驱动, 确认GPU显存顺便加个QQ群下cuda

首先要确保自己的电脑安装好了显卡驱动, QQ群号: 143626394, 在群文件里下cuda和cudnn

下载GPU-Z: https://www.techpowerup.com/gpuz/

官网下载慢可使用国内腾讯源: https://pc.qq.com/detail/14/detail_2074.html

打开GPU-Z查看显存大小, 下图中标注的Memory Size就是显存大小, 4096MB, 将4096除以1024可以得到4, 即4GB显存

第二步: 确认显存大小后, 下载对应的模型

在ChatRWKV中, 据作者描述, 目前有三种模型可供部署, 用户可以根据自己的显存选择部署, 但是最小的模型也需要至少3GB的显存, 所以显存不到3GB的同学可以放弃这篇文章了, 可以使用CPU模式, 博主没看

原文:

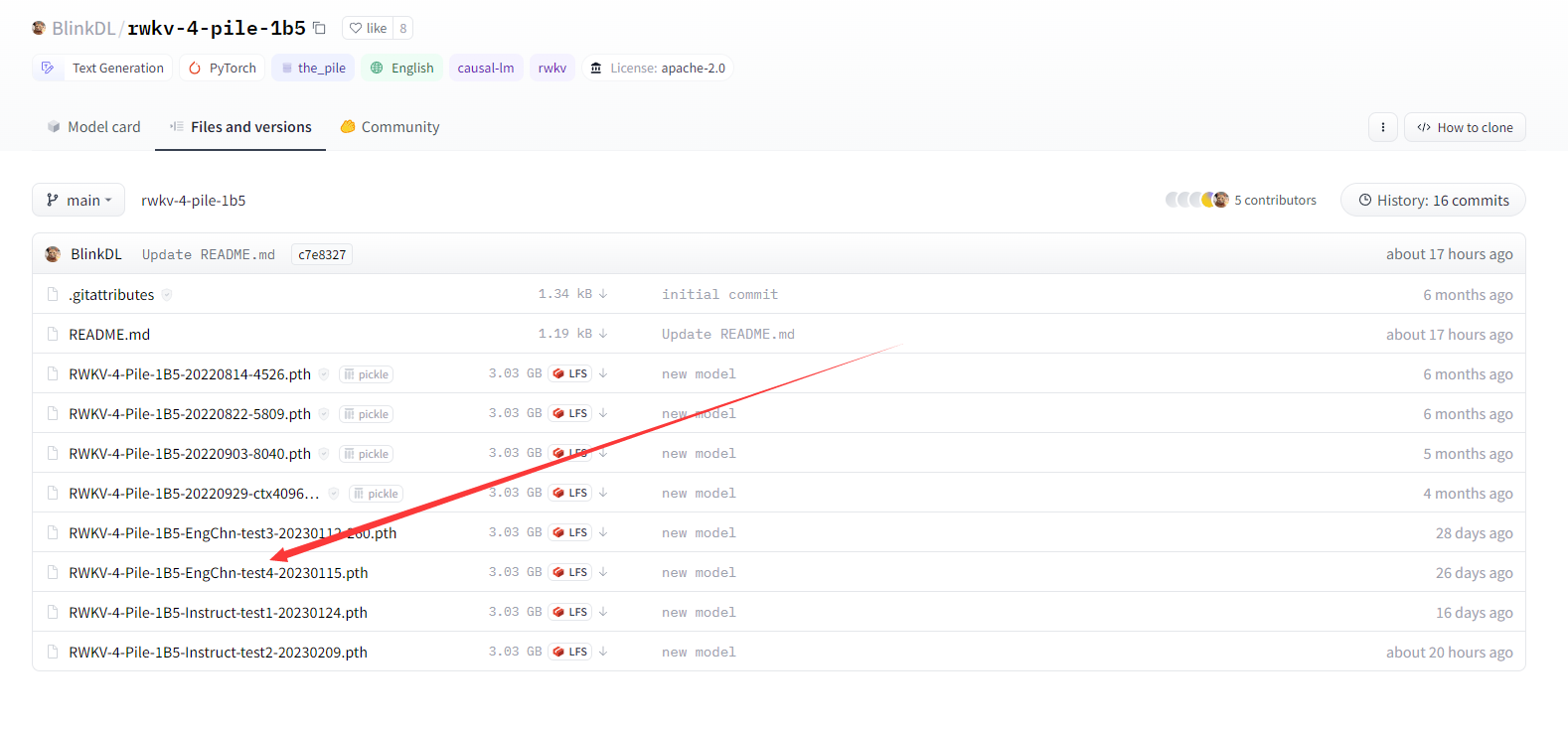

必须下载双语模型(EngChn),选最新的,目前最新是 test4 系列。

大模型:7B 参数,需 14G 显存,效果好(以后可以优化显存占用和速度,但现在忙): https://huggingface.co/BlinkDL/rwkv-4-pile-7b/tree/main

中模型:3B 参数,需 6G 显存,效果中等: https://huggingface.co/BlinkDL/rwkv-4-pile-3b/tree/main

小模型:1.5B 参数 ,需 3G 显存,效果差些: https://huggingface.co/BlinkDL/rwkv-4-pile-1b5/tree/main

如果没显卡,或者显存不够,可以用 cpu 模式(很慢)。

大模型: https://huggingface.co/BlinkDL/rwkv-4-pile-7b/tree/main

中模型: https://huggingface.co/BlinkDL/rwkv-4-pile-3b/tree/main

小模型: https://huggingface.co/BlinkDL/rwkv-4-pile-1b5/tree/main

根据你的显卡, 选择要部署的模型, 这里我选择小模型进行部署, 只需要下载最新的test4系列模型下载就可以了

如下图, 点进去文件, 选择download即可下载

第三步: 安装cuda和cudnn

先安装群文件中的cuda, 文件名为: cuda_11.1.1_456.81_win10.exe

按照顺序安装就行, 只要不报错, 弹啥都不用管

安装好后, 打开目录: C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.1

然后打开cudnn, 文件名: cudnn-11.2-windows-x64-v8.1.1.33.zip

把压缩包内的内容直接拽进去, 如图所示

然后就安装好了

第四步: 安装支持cuda的pytorch

首先电脑里要有Python, pip, 这俩玩意还得再环境变量里, 不懂的话可直接百度Windows系统安装Python3

这步比较简单, 直接win+R键输入cmd回车, 出来个黑窗口, 输入以下命令回车, 等着就行

pip install torch==1.9.0+cu111 torchvision==0.10.0+cu111 torchaudio===0.9.0 -f https://download.pytorch.org/whl/torch_stable.html

如果下载太慢, 就用下面这个

pip install torch==1.9.0+cu111 torchvision==0.10.0+cu111 torchaudio===0.9.0 -f https://download.pytorch.org/whl/torch_stable.html -i https://pypi.tuna.tsinghua.edu.cn/simple

第五步: 克隆repo并修改代码

电脑里有Git的话直接

git clone https://github.com/BlinkDL/ChatRWKV.git

没有Git的话直接下载zip解压

下载链接: https://github.com/BlinkDL/ChatRWKV/archive/refs/heads/main.zip

弄好的之后应该是这样的

有代码编辑器就用代码编辑器, 没有的用记事本编辑就行

打开chat.py, 如果用中文的话需要将22行的CHAT_LANG变量修改为Chinese

24行的话酌情更改, 想闲聊就保持False不动, 主要想问问题的话就设置成True, 首字母一定要大写

如下图所示:

然后更改30行和41行的模型路径, 需要找到你在第二步中下载的pth文件, 将pth文件的路径一字不差的写到这

斜杠用普通的/就行, 不需要用\, 也不用写.pth的后缀名

如下图所示:

第六步: 运行ChatRWKV

直接打开cmd, 运行命令即可

python chat.py

如下图所示:

然后就可以自由的跟它交流了

大佬,第六步里的图片视频是怎么制作出来的\#(观察)

网站和域名卖吗?加个QQ好友864716046,以后想卖随时可以找我

不明觉历,还是要评论一发。@(吐舌)